L’économie est-elle une science ?

ANALYSE : Question épistémologique par excellence, celle de la scientificité d’une discipline prend une dimension particulière avec l’économie, tant son poids dans la société humaine et parmi ses dirigeants est lourd. Jacques Sapir part du consensus méthodologique inquiétant qui existe dans la recherche pour remonter à Karl Popper, dont le « falsificationnisme » est largement inopérant quand il est appliqué à la science économique, avant d’étudier les positions hétérodoxes en économie, notamment la théorie des conventions ou l’école de la régulation. Un récit épistémologique long, mais passionnant, dont la technicité n’entrave pas la dimension pédagogique.

Jacques Sapir est un économiste français, aussi auteur d’ouvrages d’histoire militaire et de théorie politique. Docteur en économie et diplômé de Sciences Po Paris, il est directeur d’études à l’EHESS, directeur du Centre d’études des modes d’industrialisation (CEMI) et a récemment été élu membre de l’Académie des Sciences de Moscou. Connu du grand public pour son rejet de la monnaie unique, il a notamment publié : La Démondialisation (Le Seuil, 2011) ; Faut-il sortir de l’Euro ? (Le Seuil, 2012) ; Souveraineté, démocratie, laïcité (Michalon, 2016) et dernièrement Souveraineté, nation et religion (éd. Le Cerf, 2017) avec Bernard Bourdin. En 2001, il a reçu le prix Turgot pour Les Trous noirs de la science économique (éd. Albin Michel, 2000).

La question de la scientificité de la science économique a donné lieu à de nombreux débats, de virulentes polémiques. Robert Shiller s’interrogeait il y a peu dans la presse sur la question de savoir si l’économie était une science [1]. Il y a de cela près de vingt ans, en 1999, deux éminents collègues, Antoine d’Autume et Jean Cartelier s’interrogeaient quand à eux pour savoir si l’économie pouvait tendre vers une «science dure» [2]. On peut, par ailleurs s’interroger sur la signification des sciences dites «dures» et, de ce point de vue, l’auteur du présent texte préfère de loin l’opposition entre sciences de la nature et sciences sociales, qui lui semble bien plus préférable. Il n’en reste pas moins que le problème est posé.

Lire aussi – La déraison de l’économie (Jean-Pierre Dupuy)

Pour tenter de clarifier les choses, ont va dans le texte qui suit explorer ce qu’est une science quand elle a à traiter de conjectures complexes et imbriquées, mais aussi des problème de la testabilité et de la scientificité, en abordant de manière critique de leg de Karl Popper. Cela permettra, du moins on l’espère, de redéfinir ce que devrait être une méthodologie opératoire pour définir non pas si l’économie est une science mais à quelles conditions les économistes peuvent avoir une pratique véritablement scientifique.

La question de la méthodologie (I)

Soutenir que la méthodologie est importante, et qu’elle représente un pan de l’activité scientifique auquel on ne peut renoncer sans renoncer à la démarche scientifique elle-même, nous entraîne sur un autre terrain, celui de la vérification de conjecture et de leur testabilité. Le problème est ici particulièrement délicat en économie, et l’un des raisons en est la nature de conjectures utilisées.

Ceci va nous permettre d’aborder d’une part le fait qu’en économie on est le plus souvent confrontés à des conjectures complexes et, ensuite, de pouvoir discuter des critères de scientificité que l’on peut utiliser en économie.

Conjectures complexes et testabilité

Un exemple sur un des grands problèmes traité par l’économie va permettre d’illustrer le problème posé par les conjectures complexes et par la testabilité des dites conjectures. Un énoncé classique nous en donne un exemple. Pour un grand nombre de collègues il est évident que «L’inflation est partout et toujours un phénomène monétaire» [3]. Ce qui était conjecture autrefois est devenu aujourd’hui un dogme car, nous dit-on, largement prouvée par maintes études économétriques. La peur de passer pour un attardé s’efforçant de réinventer la roue est souvent suffisante pour clore sur ce point la discussion. Pourtant, les choses sont bien moins évidentes qu’on ne l’affirme. Outre quelques doutes que l’on peut avoir sur les travaux économétriques eux mêmes, le passage d’une observation à une affirmation devrait faire sourciller tout esprit un peu critique.

Cet énoncé, pourtant, vaut mieux que sa mythification ou son rejet pur et simple; il fonctionne en réalité comme les poupées russes emboîtées, et le processus de démontage de l’ensemble est hautement instructif quant aux fondements de l’économie. Soutenir l’existence d’un lien étroit et mécanique entre les variations de la masse monétaire et celles des prix revient à affirmer deux choses différentes, car en vérité on se repose sur une autre conjecture qui peut ainsi s’énoncer: les agents ont des comportements tels qu’un accroissement de moyens de paiement, toutes choses égales par ailleurs, nous conduit à la dévalorisation de ces moyens en comparaison du stock de biens et de services disponibles. Ce qu’il faut alors élucider c’est l’origine de ces comportements. Soit, donc, on affirme qu’ils sont donnés aux agents économiques. Dans ce cas l’énoncé initial n’est rien d’autre qu’une conséquence d’une hypothèse sur des caractéristiques immanentes à la nature humaine. Il existe un personnage, l’homo economicus, programmé de telle manière que, effectivement, un accroissement de l’offre de moyen de paiement entraînera une hausse des prix. Soit on affirme que ces comportements sont déterminés par le cadre institutionnel et le contexte dans lequel les agents se meuvent. Alors, l’énoncé initial n’a de validité que dans le cas où ces institutions, et ce contexte, sont réellement réunies. Cette distinction est extrêmement importante pour l’interprétation des résultats des tests économétriques.

Lire aussi – Rejeter le libéralisme ? (Jacques Sapir)

Dans le premier cas, l’établissement d’une et une seule relation entre monnaie et inflation suffit pour valider l’énoncé initial. Dans le deuxième au contraire, il faudrait établir cette relation pour la totalité des configurations institutionnelles existantes, passées et à venir, pour qu’il y ait validation. A défaut de tester chaque de ces deux hypothèses sur les comportements, l’établissement d’une relation entre monnaie et prix renvoie à une indétermination théorique. En tous les cas, cette relation ne peut certainement pas permettre de trancher entre les hypothèses de comportement.

Cet exemple permet de montrer un point fondamental pour la compréhension du discours économique. Il repose presque toujours sur des conjectures complexes ou emboîtées qui ne sont donc jamais directement testables. Pour pouvoir avancer, il nous faut donc désemboîter les conjectures, les déconstruire. Alors est-il possible d’en tester certaines, et on verra par la suite que c’est le cas avec les hypothèses de comportement des agents. Mais cette possibilité est elle-même limitée. La testabilité des conjectures, dans un domaine ayant trait aux activités humaines, est toujours mise en cause par la multiplicité des paramètres et la nature de ces derniers.

Lire aussi – Michael Sandel : Ce que l’argent ne saurait acheter (Jean-Pierre Dupuy)

Quand un enseignant en économie prononce devant ses élèves ou étudiants l’expression consacrée «toutes choses étant égales par ailleurs» [4], il ne fait que nier, à des fins pédagogiques ou démonstratives, cette multiplicité. Il suppose en effet que l’on puisse, dans les activités humaines, modifier un paramètre sans que l’ensemble des relations en soit affecté. Autrement dit que les opérateurs humains cessent de s’interroger sur leur propre futur et de se demander ce que pourrait impliquer pour eux un tel changement. Écrivant cela, on ne récuse pas d’emblée la modélisation, qui repose bien entendu sur cette clause «toutes choses étant égales par ailleurs». Comme outil pédagogique, elle a bien des attraits. Mais, s’il faut utiliser une comparaison, un modèle n’est jamais qu’un simulateur. Et tout pilote qui s’entraîne sur un simulateur sait que le vol réel peut lui réserver bien des surprises, aussi perfectionnée que soit la machine dans laquelle il s’entraîne. La distinction entre un formalisme mathématique assis sur une axiomatique rigoureuse, et une approche permettant de rendre opérationnels des résultats, a fait l’objet d’un certain nombre de travaux en économie [5]. Ce qui est en cause ici, c’est le passage de la pédagogie à la démonstration. Il n’est d’ailleurs pas innocent que l’on puisse glisser aussi facilement du registre de l’enseignement à celui de la discussion et de la conviction. Dans une démonstration, on prétend emporter l’adhésion de ses égaux, alors que dans un enseignement on transmet dans un cadre hiérarchique des propositions que l’on est en droit de simplifier à loisir. User des méthodes de la pédagogie là où il y a discussion, c’est implicitement nier l’égalité initiale des statuts, et donc subvertir le principe même de la discussion.

Il convient, ensuite, de prendre en compte la nature des paramètres utilisés. Les statistiques économiques sont parfois des animaux bien étranges et bien malicieux pour celui qui n’y prend garde. un simple exemple permettra de saisir l’ampleur du problème. Imaginons un pays dont les habitants, à la période initiale, produisent deux biens. le premier sert à leur consommation alimentaire, et il est produit dans le cadre d’exploitations familiales et non commercialisé. Le second est entièrement vendu à l’étranger et sert à payer les autres dépenses. Supposons que, dans une seconde période, les habitants de ce pays, considérant les prix relatifs de ces deux bien sur le marché mondial, décident de ne plus produire que le second, et d’acheter aussi à l’étranger leur consommation alimentaire. Si on calcule le PIB de ce pays, on mesurera une forte croissance de la première à la deuxième période, sans que cela implique que la richesse réelle du pays ait augmenté dans les faits. Le paradoxe vient de ce que le PIB (ou le PNB) ne mesure que la production commercialisée. Imaginons maintenant que, au lieu de deux périodes, nous ayons deux pays différents. Le premier, celui où une large partie de la production est autoconsommée, apparaîtra dans les statistiques internationales, comme bien plus pauvre que le second. Et l’économiste, qui voudrait mesurer ce que l’ouverture sur le marché mondial apporte en richesse aux économies nationales pourra conclure, s’il n’y fait garde, que cet exemple prouve indiscutablement les bienfaits de l’ouverture.

Lire aussi – Gauche, droite et souveraineté (Jacques Sapir)

Il faut donc se souvenir en permanence, quand on parle de tests économétriques, de “preuves” statistiques, que les statistiques ne sont pas la réalité, mais une traduction normalisée de la réalité. Elles ne sont pas, non plus, une pure manifestation de l’imagination du statisticien, personnage en réalité plus honnête qu’on ne le croit, et que les économistes ne veulent l’admettre.

Mais, elles ne font que traduire une certaine réalité en fonction d’une norme donnée. La question qu’il faut toujours se poser est de savoir si la norme utilisée a un sens compte tenu de la réalité que l’on veut traduire. Pour des pays dont le niveau de commercialisation des activités productives est comparable, il n’y a aucun danger à user du PIB. Mais, si les structures sociales et économiques sont hétérogènes, alors la question de la norme de traduction devient essentielle.

Or, l’utilisation des statistiques économiques comme “preuves” implique que l’on se livre à des comparaisons étendues, pour que les résultats soient généralisables. On est donc obligé, d’emblée, d’inclure des situations fortement hétérogènes.

Critères de scientificité

Arrivé en ce point, il serait facile d’en déduire le non-lieu scientifique de l’économie. Mais une telle proposition, dont on peut comprendre les origines quand on observe à quel point le discours économique est instrumentalisé pour dire une chose et son contraire, repose en réalité sur une illusion: serait scientifique ce qui produirait de la Vérité. Or, et au contraire de la tradition issue de Karl Popper, il est difficilement admissible de croire en une progression régulière sur la base de l’interaction entre des conjectures réfutables et des expériences pertinentes [6]. De ce point de vue, la tradition méthodologique de l’économie standard ou dominante est lourdement fautive.

Les économistes néoclassiques se sont, dans leur grande majorité, ralliés dès 1938 aux thèses de Karl Popper [7]. Ils ont voulu chercher dans le principe de réfutation, le falsificationisme, une garantie de scientificité. La démarche de Popper est en effet attrayante au premier abord pour une économie découvrant les délices de l’économétrie et supposant qu’elle pourrait bientôt tester la totalité de ses conjectures. Ceci permettait aussi d’esquiver le débat sur le réalisme des hypothèses initiales, débat porté par les courants contestataires qu’ils soient institutionnalistes ou marxistes. Enfin, cette démarche était cohérente avec le parti-pris de rigueur axiomatique introduit par Walras à la fin du XIXème siècle [8]. La référence à Popper va rester un point obligé pour les quelques économistes de ce courant intervenant dans le domaine de la méthodologie [9]. Le modèle visé étant ici la science physique [10], avec en particulier la proposition de Paul Samuelson de prendre comme base de départ l’hypothèse ergodique [11], et l’objectif affiché celui d’obtenir pour l’économie le statut d’une science «dure» [12]. Dans le même temps, elle fonde l’instrumentalisme de Milton Friedman, qui récuse d’emblée tout débat sur le réalisme des hypothèses [13]. On passe alors, pour reprendre la formule de Bruce Caldwell à un empirisme logique qui succède au positivisme logique [14]. Cet instrumentalisme va se retrouver en dehors même du courant néoclassique ; Oliver Williamson, l’un des «pères» du néo-institutionnalisme va ainsi encore prétendre en 1985 que le caractère potentiellement falsifiable d’une conjecture est plus important que son réalisme [15].

Lire aussi – Le management : une question philosophique (Eric Delassus)

Le falsificationisme poppérien soulève cependant plus de problèmes qu’il ne peut en résoudre. Il se heurte tout d’abord à la conjecture de Duhem et Quine [16]. Cette dernière est particulièrement importante dans le cas qui nous conerne. Pour que la testabilité soit robuste au sens de Popper, il faudrait que l’on puisse tester les conjectures seules et que les méthodes d’évaluation des résultats ne soient dépendantes de la théorie que l’on veut tester. Ceci est très exactement le problème que l’on a évoqué à propos des sources de l’inflation. Ce problème, déjà important en physique, devient rédhibitoire en économie où les agrégats utilisés pour quantifier ne font que normaliser une réalité à partir de conjectures théoriques implicites [17]. Un second problème tient à la nature des prévisions par rapport au mode de testabilité. Dans la grande majorité des cas les prévisions sont qualitatives (la création monétaire est source d’inflation), alors que la vérification est quantitative [18]. Un troisième tient à la manière même dont Popper utilise la réfutation et la falsification. Pour lui la falsification doit engendrer un rapprochement des théories avec la réalité, et le progrès théorique doit se mesurer à la capacité à expliquer des faits nouveaux. Or, non seulement Popper lui-même admet que le premier critère est invalidable [19], mais de plus l’économie vérifie toujours ses conjectures sur des événements passés [20].

Dans ces conditions, on ne doit pas s’étonner d’une très large remise en cause de l’applicabilité de la méthodologie poppérienne [21].

Les limites de cette méthodologie ont entraîné un certain nombre d’économistes qui refusent d’abandonner l’empirisme logique à se pencher vers l’œuvre de Imre Lakatos [22]. Ce dernier propose de mettre l’accent sur des programmes de recherche qui seraient définis par un noyau dur d’hypothèses, réputées infalsifiables, et une ceinture protectrice d’hypothèses, elles falsifiables et réfutables, et pouvant être remplacées. La cohérence, et la scientificité d’un tel programme de recherche découlant de la capacité du noyau dur à engendrer des prévisions et de sa cohérence interne. Lakatos appelle ainsi dégénérescence d’un programme l’introduction, au sein du noyau dur, d’hypothèses ad-hoc.

Une telle démarche présente tout à la fois des différences substantielles et des ressemblances avec celle de Popper. La notion de noyau dur, l’idée que le progrès scientifique puisse venir de la corroboration de conjectures et non de leur réfutation marquent les différences. Néanmoins, l’accent mis sur la testabilité, ou la falsification, ainsi que l’idée de prévision, renvoient clairement au cadre poppérien.

Lire aussi – Crise de la démocratie et souveraineté (Jacques Sapir)

Les économistes du courant standard, ou « mainstream », ont rapidement vu l’intérêt d’une telle approche. Le noyau dur du programme de recherche qualifié alors de scientifique (ce qui implique que les autres ne le sont pas…) est alors caractérisé par la théorie des préférences de l’agent, l’hypothèse d’individualisme méthodologique et la maximisation sous contrainte [23]. La définition d’un tel noyau dur est cependant loin d’être facile, compte tenu des tensions internes de ce courant [24].

Néanmoins, avant même que ces économistes aient commencé à se référer explicitement à la démarche de Lakatos, d’autres travaux en avaient montré les limites. Ainsi, on peut considérer que la part poppérienne chez Lakatos est tout aussi vulnérable que Popper lui-même au problème de Duhem-Quine, comme le montre l’impossibilité par exemple de trancher entre un programme de recherches monétariste ou keynésien sur la base des critères proposés par Lakatos [25]. Il faut aussi ajouter que, comme signalé à propos de Popper, le fait de l’économie procède par relecture successive de problèmes et d’événements et non par prévision et prédiction, rend inapplicable la méthodologie proposée par Lakatos [26]. Par ailleurs, si on applique cette méthodologie au courant dominant en économie, il est clair que ce dernier a procédé, depuis la fin des années soixante-dix, à l’introduction d’un certain nombre d’hypothèses ad-hoc dans son noyau dur, comme la prise en compte des institutions. En ce sens, on pourrait soutenir que, du point de vue de la démarche de Lakatos, le programme de recherche du courant standard ou mainstream est effectivement dégénéré.

Lire aussi – Stratégie et entreprise : fallait-il brûler tout Marx ? (Bruno Jarrosson)

Dans ces conditions, le constat d’une crise méthodologique au sein du courant dominant semble devoir être évident. Sheila Dow montre [27], dans une récente recension, que les différents auteurs du «mainstream» s’opposent désormais entre un camp se réfugiant dans une axiomatique irréaliste, dans la tradition ouverte par Friedman en 1953, et un autre recourant à l’empirisme, mais sans garde-fous si ce n’est que techniques en matière de procédures de vérifications [28]. Dans un tel contexte, on comprend alors l’intérêt que suscitent au sein de ce courant les théories déniant toute importance à la méthodologie, qu’il s’agisse des thèses sur la pure dimension rhétorique de l’économie, défendue par McCloskey, ou des positions de type post-moderne se réfugiant dans l’hyper-critique [29].

Or, ces deux approches ont pour effet immédiat de transformer l’économie en pure apologétique. Les thèses de McCloskey sur la dimension rhétorique soulèvent un problème réel. Il serait naïf de nier une dimension rhétorique au discours économique. Il n’en reste pas moins qu’en en faisant la seule dimension possible, il aboutit à cette merveilleuse thèse panglossienne que, les bonnes conjectures étant les plus convaincantes, la majorité a toujours raison car elle a été convaincue. Peut-être est-il bon, alors, de rappeler cette citation de W. Jevons, que tout chercheur en sciences sociales se devrait de connaître par cœur :

«Un calme despotique est le triomphe de l’erreur; dans la République des Sciences, la sédition et même l’anarchie sont dans le long terme favorables au plus grand bonheur du plus grand nombre» [30].

Il n’en reste pas moins cependant que, si la constante remise en cause des idées dominantes est nécessaire, il doit y avoir débat et non vacarme. Une situation où tout pourrait être soutenu sans conséquences, car sans procédures de vérification, ne serait pas moins despotique qu’un calme imposé par une main de fer despotique. Un débat sans procédures est un débat sans enjeu; ce n’est plus un débat. Voici donc à quel désastre pourrait aboutir la diffusion des thèses post-modernes, une dictature non moins dangereuse que celle du despote visible, au règne duquel le tyrannicide peut au moins mettre fin.

Refuser des procédures de vérifications au prétexte qu’elles sont imparfaites est un comportement qui relève de l’infantilisme. Il faut se pencher sur les méthodes permettant de limiter les imperfections, et d’améliorer les procédures, même si l’on sait que la perfection est un objectif hors d’atteinte. Depuis des millénaires, les médecins finissent par perdre leur bataille contre la maladie; leurs malades finissent bien par mourir. Ils n’en n’ont pas pour autant décidé que la médecine était une activité sans objet puisque son triomphe ultime, l’immortalité, était hors de portée. C’est le fond de la condition humaine que de mener des batailles qui sont le plus souvent perdues, ou qui au mieux n’engendrent que des succès temporaires et limités. Ce n’est pas pour autant qu’il faut cesser de se battre.

Pour une nouvelle méthodologie économique (II)

Le processus de la recherche scientifique est donc d’une toute autre complexité que les simplifications positivistes ou post-modernistes dans lesquelles les économistes du courant dominant se réfugient actuellement. Ce comportement, qui s’allie à un mépris implicite ou affiché pour les questions de méthodologie, est une caractéristique de la décadence d’une certaine économie. Toute activité à vocation scientifique qui s’avère incapable de débattre des conditions de vérification de sa pratique se nie elle-même.

La robustesse d’un fait scientifique résulte, comme le rappelle opportunément Michel Callon, d’un alliage entre des réseaux humains, des pratiques reconnues, un intérêt de la part d’un utilisateur potentiel. Cette robustesse est donc forcément temporaire, toujours susceptible d’être minée par le doute quand les réseaux se décomposent et se transforment, les pratiques évoluent, les intérêts se déplacent [31]. Une partie de l’incompréhension engendrée par le statut des résultats en économie, vérités révélées ou simples affirmations idéologiques, tient dans les illusions qu’engendre l’aveuglement volontaire sur les modes de vérifications. Pour en sortir, il faut accepter la séparation radicale entre le statut d’une discipline dans la typologie générale des sciences, et la nature des pratiques des chercheurs opérant au sein de cette discipline. Savoir si, oui ou non, l’économie peut prétendre au statut de science dite « dure » n’a en réalité aucun intérêt, si ce n’est, mais dans un autre contexte, celui de valoriser l’économiste dans ses relations avec le décideur politique. Par contre, la question des pratiques des économistes est, elle, absolument fondamentale.

Critères de repérage

Un regard rétrospectif sur l’épistémologie de Keynes s’avère ici nécessaire si on veut pratiquer de manière efficace la distinction entre science et pratique scientifique [32]. En économie, la part des «évidences disponibles», c’est à dire des énoncés qui font si ce n’est l’unanimité de la profession, du moins qui sont admis par un grand nombre de chercheurs, jouent un rôle déterminant [33]. La controverse, et l’on retrouve ici un thème cher à Michel Callon, devient un élément décisif de la vérification de la pratique scientifique.

Cette controverse, et l’histoire des controverses passées, permet de séparer le poids d’un énoncé de sa probabilité. Par poids, il faut entendre, à la suite de Keynes lui-même [34], la quantité d’évidences disponibles pertinentes à un argument donné, et leur cohérence réciproque. Soutenir ainsi un énoncé par des évidences disponibles issues de champs méthodologiques opposés diminue au lieu de l’accroître le poids de l’énoncé. La probabilité d’un énoncé renvoie quant à elle au degré de vérification des évidences disponibles. Avoir une démarche scientifique, pour un économiste, ne peut donc signifier n’émettre que des conjectures testables et vérifiables. A ce compte, il serait silencieux la plupart du temps. Cela veut dire dans un premier temps évaluer, par les controverses présentes et passées, le poids des énoncés dont il se sert ou qu’il veut réfuter. Puis, quand il le peut, soumettre les évidences disponibles à l’épreuve de la vérification, tout en sachant que, du fait même de la nature de la discipline, cette dernière ne peut être que limitée et imparfaite. La vérification joue donc ici moins le rôle de l’établissement d’une preuve que de l’invalidation de certaines conjectures.

Lire aussi – La loi contre le légalisme : quand le droit tue la politique (Jacques Sapir)

Si l’énoncé A, repose strictement [35] sur les évidences x, y, z, qui elles mêmes sont liées à des conjectures a, b et g, et que l’une de ces conjectures soit testable, la validation de l’une ne prouverait pas l’énoncé, mais l’invalidation de l’une serait suffisante pour amener au rejet de l’énoncé. Se plier à cette discipline ne garantit nullement que les résultats soient «vrais», mais établit la distinction entre une pratique scientifique de l’économie et une pratique idéologique, où les énoncés visent d’abord et avant tout à justifier des options métaphysiques ou politiques sous-jacentes [36]. Pour s’orienter au sein des controverses, des modes de repérages sont nécessaires pour déterminer quelles sont les évidences disponibles compatibles et celles qui ne le sont point. La question de la définition d’une orthodoxie (et par là même de diverses hétérodoxies) est à cet égard secondaire. Dans les rapports de force au sein d’une discipline largement institutionnalisée, ces distinctions sont importantes. Mais le lecteur de ce livre n’a pas, a-priori, à être concerné par les querelles intestines de la profession. Par contre, bien comprendre ce qui oppose sur le fond des courants qui sont par ailleurs riches et divers, est dans notre contexte, primordial.

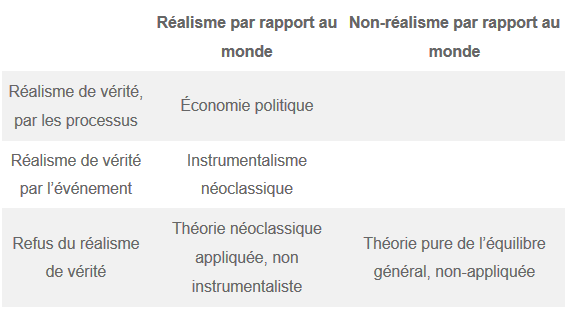

Un mode de repérage a déjà été proposé au moment de l’affirmation de l’École des Conventions [37]. Il permet, à partir des deux axes constitués par le choix du mode de rationalité (maximisatrice ou procédurale) et par la place accordée aux notions de marché et d’organisation, de dégager des oppositions instructives entre ce qui est qualifié de Théorie Standard (i.e. la théorie de l’équilibre générale dans ses présentations les plus traditionnelles), les modifications progressives apportées par l’élargissement du programme de recherches de cette Théorie Standard, et différentes hétérodoxies. Pour élégant qu’il soit, en particulier dans sa discrimination entre les différentes formes de ce qui y est appelé la Théorie Standard, ce repérage souffre de deux défauts. Il est construit sur des objets (ou plus exactement des oppositions entre objets) et non sur des fondements de démarche, et il est muet quant aux délimitations des Théories Non-Standard. De manière à peu près contemporaine, des critères plus fondamentaux ont été proposés autour des notions de réalisme [38], et de l’opposition entre événement et processus [39].

Le réalisme processuel

La question du réalisme est centrale; elle fait rupture avec l’instrumentalisme défendu par M. Friedman. On est ici en présence d’un problème qui dépasse de loin l’économie et concerne la totalité des sciences sociales. Ce n’est certainement pas un hasard si l’importance du réalisme, d’un point de vue méthodologique, a été soulignée à partir de l’histoire sociale [40]. L’application de cette notion en économie a été tout autant négative que positive. Dans le versant négatif, elle permet d’articuler une critique ravageuse contre l’instrumentalisme [41], critique qui touche non seulement les monétaristes et les partisans des anticipations rationnelles, mais un grand nombre de positions de l’économie dominante, y compris le néo-institutionnalisme à la Williamson. Elle a un versant positif, en ce qu’elle décrit une approche qui, rompant avec l’empirisme logique, articule les niveaux d’abstraction [42].

On trouve ainsi chez Uskali Mäki la distinction entre le «réalisme par rapport au monde» (ou World realism), qui implique qu’une théorie économique ait pour objet la compréhension du monde tel qu’il est (et non tel que l’on souhaiterait qu’il fût), et le «réalisme de vérité» (ou Truth realism), qui implique que l’on juge d’une théorie dans sa confrontation au monde et pas seulement sur ses critères de cohérence interne ou de conformité aux axiomes initiaux [43]. Le critère de Mäki soulève bien entendu le problème de ce que l’on considère comme le «monde objectif». Il est indiscutable qu’il peut donner lieu à une dérive positiviste. Si on l’interprète en terme de contexte, intégrant donc non seulement les institutions, mais aussi l’état des sciences et techniques et surtout l’ensemble des représentations que les acteurs ont, et d’eux-mêmes et des autres, et de leur position propre et du monde dans lequel ils se meuvent, la notion de «monde» ressemble plus à ce qu’une tradition française de lutte contre le positivisme a enseigné. Néanmoins, on peut déjà constater que le «réalisme de vérité» marque une opposition nette avec les approches instrumentales. En ce sens, il y a parallélisme entre ce que propose Mäki et la nécessité invoquée il y a peu de revenir à un contenu descriptif fort contre les stratégies purement axiomatiques qui n’ont en fait d’autre but que d’immuniser celui qui les emplois contre les rencontres dérangeantes avec le monde réel [44].

Le second critère permet par ailleurs de corriger les possibles dérives engendrées par le premier. Lawson [45], oppose ainsi, à l’intérieur du critère de «réalisme de vérité», la démarche où la vérification se fait à partir d’événement et celle où elle se fait sur la base d’une explicitation des processus, et donc des relations causales, qui ont donné naissance aux événements. La notion de processus, et surtout de procès, est au cœur de l’approche de Marx d’ailleurs tout comme elle est aussi centrale chez Keynes [46]. On ajoutera cependant que la détermination du processus ne peut être le seul critère de validation d’une théorie; il faut y ajouter les modes de construction (et leur critique) du processus dans cette théorie ainsi que le montre Michel Callon [47]. Sur la base de ces deux critères, une classification a été proposée par Sheila Dow, et qui a l’immense intérêt de bien préciser où sont les oppositions de paradigmes [48].

L’auteur de cette classification intègre, dans ce qu’elle appelle l’Économie Politique, non seulement le Post-Keynesianisme [49], mais aussi certains courants marxistes, les institutionnalistes, des théories comportementalistes, les neo-autrichiens et même certains courants de l’école standard. En terme de discrimination au sein de ce que Favereau avait appelé la Théorie Non-Standard on n’a guère avancé, même si les critères sont incontestablement plus généraux et ne supposent plus l’hypothèse, lourde, de ne considérer que des théories se réclamant de l’individualisme méthodologique [50].

En fait, l’auteur de cette classification laisse volontairement de côté la question d’une meilleure définition à l’intérieur de l’Économie Politique. Elle soutient que l’unité d’une approche ne provient pas de ses méthodes qui doivent être diverses, mais de la vision globale qui les unit [51]. Cette vision globale, dans le cas des post-Keynesiens, est alors directement politique. La démarche de Sheila Dow semble critiquable ici, à moins de n’avoir que des définitions très larges et ouvertes des méthodes. L’empilement d’argumentaires collectés dans des cadres méthodologiques différents et parfois opposés est d’ailleurs une solution proposée par les économistes du courant dominant les plus conscients de la crise méthodologique de leur démarche [52]. Si une telle approche a incontestablement un intérêt par rapport à l’enfermement sectaire des partisans de l’instrumentalisme et de l’axiomatique à tout prix, elle peut aboutir à des incohérences qui détruisent le poids de l’énoncé que l’on veut établir.

Lire aussi – L’avenir du travail (Dominique Méda)

Un exemple de cela peut être fourni par une anecdote arrivé à l’auteur de ces lignes en 1992. Il se souvient d’avoir entendu au FMI une autorité de cette organisation proférer que «…l ‘inflation est partout et toujours un phénomène macro-économique comme l’a montré Hayek». Il se fait que Hayek a expliqué en fait le contraire ; l’inflation traduit, pour lui, les frictions au niveau des ajustements micro-économiques des prix relatifs. On peut être en accord avec Hayek ou le contester ; on peut considérer l’inflation comme un phénomène purement macro-économique ou non. On ne peut mélanger les deux registres sous peine d’incohérence. Tel est le danger de l’éclectisme.

Voila pourquoi on accorde aux critères de repérage une singulière importance. Ce n’est pas par souci de découper le monde en «bons» ou «mauvais» économistes, mais pour se souvenir que les arguments échangés dans les controverses ne sont par interchangeables. La cohérence de l’argumentaire est un des critères d’évaluation du poids d’un énoncé.

Éléments d’une méthodologie ouverte

Des éléments de critique de la méthodologie dominante, et de ses avatars, que l’on vient de présenter on peut dégager une direction alternative, aboutissant à un type de méthodologie ouverte. Pour y parvenir, il faut reprendre certains des problèmes évoqués, et en premier lieu celui de la sous-détermination, c’est à dire le fait que des données économiques peuvent être utilisées pour justifier des explications dans des cadres théoriques complètement différents. Uskali Mäki écrit ainsi :

«La thèse de la sous-détermination proclame que les données et la logique sont insuffisantes pour contraindre le scientifique à une décision unique en terme d’adhésion ou de rejet d’une théorie donnée. Comme nous savons que de telles décisions sont prises dans les faits, nous devons admettre que d’autres contraintes se glissent ici, si nous ne voulons admettre que le procès est complètement aléatoire» [53].

Cette remarque est particulièrement importante, car elle renvoie en fait au statut double, analyste et acteur, de l’économiste. Mäki suggère que d’autres contraintes finissent par s’introduire dans le cadre conceptuel de l’économiste. Si nous considérons ce dernier dans sa fonction d’analyste, ceci pose le problème de la nature du système qu’il observe et analyse. Pour qui, à la suite de Samuelson, considère que l’économie est assimilable à un système ergodique au sens fort du terme, alors même si les observations ne sont pas directement révélatrices de lois du système, elles n’en engendrent pas moins une convergence, sous l’hypothèse que le comportement de l’analyste soit lui-même rationnel [54]. Dès lors la sous-détermination n’est que temporaire. Supposons, maintenant, que l’économie n’admette que des ergodicités limitées, soit qu’elle n’existe que sous la forme de systèmes locaux et temporaires. Alors, la sous-détermination résulte d’une incapacité à collecter assez de données dans les plages de stabilité, et de l’impossibilité de comparer directement les données provenant de systèmes différents. La sous-détermination est ici structurelle et la non-convergence des interprétations ne relève pas d’un manque de rationalité mais bien d’une incapacité de fait à trancher sur la simple base des données. Si, enfin, on accepte de se placer dans l’hypothèse où l’économie ne relèverait jamais d’une hypothèse ergodique, et ce sous quelque forme que l’on puisse l’exprimer, alors la sous-détermination serait fondamentale , et la non-convergence ne résulterait pas d’une incapacité de fait, mais d’une impossibilité de principe.

Lire aussi – Un bonheur sans croissance est-il possible ? (Anne Frémaux)

Une méthodologie ouverte doit pouvoir fonctionner dans ces trois cas de figure, car supposer une adéquation de la méthodologie avec une de ces hypothèses, c’est supposer que nous connaissons déjà le résultat de notre programme de recherche au moment où nous en établissons les règles de fonctionnement.

Maintenant, si on admet que l’économiste n’est pas seulement un observateur mais aussi un acteur, et qu’il peut, à travers les conseils qu’il prodigue à un gouvernement, ou à une puissance privée de grande importance, peser sur les règles de fonctionnement du système, le problème se déplace. D’une part la nature de la rationalité de l’économiste change, puisqu’il est à la fois dans une posture d’analyse et de justification. D’autre part, si l’ergodicité du système peut être affectée par des changements de règles et d’institutions (ou plus précisément si nous ne pouvons exclure qu’il puisse en être ainsi), alors le statut des données collectées change à son tour, et ce d’autant plus que le projet analytique peut être remplacé par un projet normatif (comment faire en sorte que le système fonctionne comme j’ai prédit qu’il devait fonctionner). On voit donc pourquoi le test par les données ne saurait être le critère, ni unique ni central, d’une méthodologie économique. Ceci plaide évidemment pour l’adoption de la cohérence interne et du réalisme comme normes d’évaluation.Le rejet symétrique des thèses positivistes (le test est le critère suprême de scientificité) et relativistes (il n’est pas de vérité, rien que du discours) conduit à retenir l’articulation de trois critères pour définir une démarche scientifique en économie :

- Il faut tout d’abord que les hypothèses soient réalistes. Cette exigence découle directement de l’impossibilité dans laquelle nous nous trouvons d’être sur de pouvoir tester une hypothèse, ou d’être sur de pouvoir interpréter le résultat du test de manière indiscutable. Cette impossibilité découle de la prise en compte de trois arguments ci-dessus évoqués: (a) le degré d’emboîtement des conjectures à tester, (b) le problème de Duhem-Quine et la non-neutralité des données utilisées dans le test par rapport à la conjecture qu’elle doivent vérifier ou invalider, (c) le caractère essentiellement qualitatif des prédictions et conjectures de l’économie, confronté au caractère quantitatif des données. Ceci condamne radicalement l’instrumentalisme.

Dire qu’une hypothèse doit être réaliste n’implique pas qu’elle soit vraie. Cela suppose simplement, mais ce simplement, on le verra, est lourd de conséquences, que l’on se refuse à axiomatiser dans le vide. Ainsi, supposer que les agents sont, en tout lieu, à toute heure, en mesure de calculer la totalité des conséquences possibles de l’interaction entre une décision et l’environnement, supposition qui est consubstantielle à l’hypothèse de rationalité maximisatrice, n’est pas réaliste. De même, supposer que le temps ne se manifeste pas sous la forme d’une contrainte dans le processus de traitement du signal avant qu’une décision soit prise, autrement dit qu’il est indifférent de prendre une décision donnée aujourd’hui ou demain, le premier ou le dernier, est une autre hypothèse irréaliste. L’exigence de réalisme est donc première; elle doit s’entendre au sens du réalisme processuel que l’on a évoqué plus haut. - Il faut ensuite que le raisonnement soit cohérent. Un raisonnement cohérent est un discours construit dans lequel on ne fait pas entrer, sous prétexte d’une explication conjoncturelle, un élément qui soit incompatible avec les prémisses. Si on suppose les marchés imparfaits, on ne peut plus invoquer par la suite un marché parfait. Si on suppose la connaissance des agents limitée, on ne peut invoquer une règle de comportement qui impliquerait, sous une forme ou une autre, une connaissance parfaite.

Un raisonnement cohérent n’est pas forcément juste. Il est des raisonnements cohérents qui, en raison du degré d’irréalisme des hypothèses de base sont évidemment faux. C’est le cas des raisonnements paranoïaques, par exemple. L’exigence de cohérence n’est en rien décisive ou suffisante; elle ne prend son sens que dans l’articulation avec l’exigence de réalisme. - Il faut enfin pratiquer une testabilité limitée. Dire que l’on ne peut pas tout tester, ou que les résultats ne peuvent être tenus pour naturellement indiscutables, ne signifie pas qu’il faille renoncer à tester. Le chercheur doit pratiquer une testabilité limitée ou critique, qui repose sur deux préambules :

- Il faut pouvoir décomposer un argument en conjectures simples. Ceci est loin d’être toujours possible, mais doit être tenté autant que faire se peut. Le simple processus de décomposition des argumentaires a déjà une valeur critique et analytique essentielle, en permettant la mise en évidence des interactions et rétroactions. La testabilité limitée s’oppose ici à l’emploi de la clause «toutes choses étant égales par ailleurs», qui implique que le système étudié soit simple, dans le sens où l’on puisse faire varier un élément sans modifier les relations de cet élément avec le reste. La testabilité limitée part du principe que les systèmes sont complexes et tente de les réduire en systèmes simples.

- Il faut procéder à une construction explicite du test , c’est à dire à une analyse critique des sources des données, des processus qui les mettent à la disposition du chercheur, de leur contenu théorique implicite (par exemple dans l’utilisation des données de PNB/PIB), du degré de généralité du test et de la procédure du test. Cette construction doit être explicite, en ce sens qu’elle doit conduire à la formulation des hypothèses qui servent à tester et pas seulement des hypothèses que l’on teste. La testabilité limitée ne peut pas être une procédure générale et systématique. Elle s’insère dans les deux précédentes exigences de réalisme et de cohérence comme forme de rapport entre le chercheur et la réalité de l’objet sur lequel il travaille.

Lire aussi – Quand valeur économique et cohésion sociale divergent (Bruno Jarrosson)

Une démarche qui associe et articule ces trois critères répond alors au méta-critère évoqué plus haut, la capacité à fonctionner quel que soit le degré d’ergodicité du système étudié. On rappelle que l’on peut être en présence de trois situations distinctes, celle où le système vérifie une hypothèse ergodique forte, celle ou n’est vérifiée qu’une hypothèse ergodique limitée et temporaire, et celle, enfin, de rejet de toute hypothèse ergodique. C’est dans le premier cas que la testabilité limitée prendra le plus de poids. Par rapport à une démarche instrumentaliste, on est au pire à égalité, et plus probablement avec un léger avantage, car la déconstruction des conjectures et des procédures assure une vérification instantanée des pratiques du chercheur, que ne permet pas l’instrumentalisme traditionnel. Si nous sommes dans le second cas, l’instrumentalisme est incapable d’engendrer une convergence des prévisions. La testabilité doit nécessairement être reléguée au second plan au profit des critères de cohérence et de réalisme. Si nous sommes dans la troisième situation, alors l’instrumentalisme est impossible par nature. Pour autant, en raison de la présence du couple cohérence/réalisme, le chercheur n’est pas dépourvu de moyens d’intelligence et de critique de sa pratique. La testabilité limitée a, ici, l’utilité de vérifier son impossibilité, ce qui serait impossible pour une démarche se fiant seulement et uniquement à la cohérence ou au réalisme.

La démarche que l’on propose n’implique donc aucune décision quant à la nature des situations auxquelles on va être confrontée. Cette méthodologie est donc ouverte au sens où elle ne présuppose pas la connaissance des résultats de la recherche pour en définir les règles. Elle est au moins égale, dans les trois situations possibles, à toute autre méthodologie qui serait spécialisée sur cette situation donnée.

Réhabilitation des méthodes non-formalisées en économie

Une telle démarche permet aussi de réhabiliter l’enquête comme forme d’approche scientifique face à la seule modélisation. En fait l’enquête, si elle est bien menée, est souvent plus scientifique que la modélisation et permet de fournir des bases à cette dernière. On a souvent en effet reproché aux auteurs du courant institutionnaliste l’emploi de modes non-formalisés de théorisation, qualifiés de «storytelling» ou de «pattern modelling» [55]. Cette critique est en fait injustifiée [56], et l’enquête est une démarche largement usitée dans les sciences sociales et pour d’excellentes raisons [57].

Pour qu’une critique radicale de l’enquête soit possible, autrement dit pour qu’une méthode entièrement déductive soit substituable comme méthodologie aux pratiques de l’enquête, il faut pouvoir supposer que le système sur lequel on travaille est stable et simple, autrement dit qu’il vérifie une hypothèse ergodique forte. Mais cette supposition implique que l’on connaisse déjà le dénouement de la recherche entreprise. Si on refuse de préjuger de l’avenir, alors rien ne confère à la démarche axiomatique une supériorité sur tout autre démarche.

Lire aussi – La nécessité de l’innovation, l’importance de la responsabilité (Xavier Pavie)

Par ailleurs, pour être maintenant recevable, une critique de l’enquête suppose que le mode d’enquête ne soit pas vérifiable. Cela peut se produire, et on peut être en présence de «storytelling» qui ne soit ni cohérent ni réaliste. Mais la pratique erronée de l’enquête ne disqualifie par la méthode en elle-même.

Enfin, si on suppose qu’il y a une probabilité, même faible, pour que le système que l’on étudie soit complexe, c’est à dire caractérisé non seulement par des interactions mais aussi par des rétroactions, alors le «storytelling» ou le «pattern modelling» bénéficient d’un important avantage comparatif sur tout autre méthode [58].

La démarche de l’enquête est ainsi un instrument important pour l’économiste. Les travaux théoriques qui ont marqué, en France, l’émergence d’un nouveau courant, L’École de la Régulation, ont été fondamentalement des enquêtes, sur les trajectoires historiques des économies américaine et française [59]. En un sens, on peut considérer que les auteurs de cette école ont pratiqué depuis plus de vingt ans le type de méthodologie que l’on défend ici. Une enquête, pour être réussie, doit associer le réalisme de ses hypothèses à la cohérence du raisonnement, tout en cherchant à pratiquer ce que l’on a qualifié de testabilité limitée.

Une nouvelle économie

L’exposé de ce texte, on l’aura compris, se situe donc explicitement dans le cadre co-défini par le «réalisme par rapport au monde» et par le «réalisme de vérité par les processus». On soutient donc que la réalité économique n’est pas directement intelligible, ce qui renvoie à l’importance des énoncés et conjectures, et par là à celle des controverses présentes et passées. En ce sens, on se situe pleinement et consciemment au sein du paradigme subjectiviste, dans un rejet de tous les positivismes. En fait, les délimitations sont même plus précises. Leur explicitation fait néanmoins partie du corps même de l’argument, et apparaîtra de manière progressive au fur et à mesure que l’on va avancer dans les débats qui concernent l’économie décentralisée. Il s’agit, en procédant de manière à la fois critique et analytique, de montrer que le courant dominant, ou «mainstream», ne peut penser l’économie qu’à partir de la métaphore de la centralisation initiale. Or, il n’y a rien d’inéluctable à un tel résultat. Bien au contraire, on peut montrer qu’il existe une longue tradition de réfutations, plus ou moins pertinentes, de ce courant dominant, qui insistent sur l’irréductible décentralisation des agents, et présentent la centralisation comme un aléatoire résultat ex-post et non comme une hypothèse ex-ante .

Lire aussi – Les inégalités économiques n’ont aucun sens moral (Ruwen Ogien)

Tenter de réfuter ce courant dominant conduit aussi à une évaluation critique des courants hétérodoxes qui se sont constitués. A cet égard, la confrontation entre les diverses écoles institutionnalistes et un bilan critique de la tradition autrichienne, se révèle riche d’enseignements. L’application des critères d’une méthodologie ouverte, tels qu’ils ont ici été définis, rend possible un approfondissement des critiques traditionnelles, et l’émergence de ce qui pourrait, à terme, constituer une synthèse.

[1] http://www.latribune.fr/opinions/tribunes/20131220trib000802153/l-economie-est-elle-une-science.html

[2] D’Autume A., et Cartelier J., L’économie devient-elle une science dure, Paris, Economica, 1999.

[3] Friedman M., The Counter-Revolution in Monetary Theory, Londres, Wincott memorial lecture, Institute of Economic Affairs. Occasional paper 33, Wincott memorial lectures, 1970.

[4] Ou clause Ceteris Paribus.

[5] Voir par exemple F.H. Hahn, « Keynesian economics and general equilibrium theory: reflections on some current debates » in G.C. Harcourt, (ed.), The Microfoundations of Macroeconomics , Macmillan, Londres, 1977. B.J. Loasby, The Mind ans Methods of the Economist: A critical appraisal of major economists in the XXth Century , Edward Elgar, Aldershot, 1989, en particulier chapitre 8. D.M. Haussman, The Inexact and Separate Science of Economics , op.cit..

[6] T.S. Kuhn, La Structure des Révolutions Scientifiques, Flammarion, coll. Champs, Paris, 1983, 2ème édition.

[7] Voir T.W. Hutchison, The Significance and Basic Postulates of Economic Theory, Macmillan, Londres, 1938.

[8] A. Insel, “Une rigueur pour la forme: Pourquoi la théorie néoclassique fascine-t-elle tant les économistes et comment s’en déprendre?”, in Revue Semestrielle du MAUSS, n°3, éditions la Découverte, Paris, 1994, pp. 77-94.

[9] Par exemple M. Blaug, The Methodology of Economics , Cambridge University Press, Cambridge, 1980.

[10] P. Mirowski, « How not to do things with metaphors: Paul Samuelson and the science of Neoclassical Economics », in Studies in the History and Philosophy of Science, vol. 20, n°1/1989, pp. 175-191. Pour une critique plus générale sur le modèle de scientificité de la physique, P. Mirowski, More heat than light, Cambridge University Press, Cambridge, 1990.

[11] P.A. Samuelson, “Classical and Neoclassical theory”, in R.W. Clower, (ed.), Monetary Theory, Penguin, Londres, 1969.

[12] J. Cartelier et A. D’Autume (eds), L’économie est-elle une science dure?, op.cit..

[13] M. Friedman, « The Methodology of Positive Economics », in M. Friedman, Essays in Positive Economics, University of Chicago Press, chicago, 1953, pp. 3-43.

[14] B. Caldwell, Beyond Positivism: Economic Methodology in the Twentieth Century, op.cit.. Voir aussi W. Mason, « Some negative thoughts on Friedman’s Positive Economics », in Journal of Post-Keynesian Economics, vol. 3, n°2/1981, pp. 235-55.

[15] O.E. Williamson, The Economic Institutions of Capitalism, Firms, Market, Relational Contracting, Free Press, New York, 1985, pp. 391-2.

[16] P. Duhem, The Aim and structure of Physical Theory, Princeton University Press, Princeton, NJ, 1954. W. Quine, « Two Dogmas of Empiricism », in W. Quine, From a Logical Point of View, Harvard University Press, Cambridge, Mass., 1953, pp. 20-46.

[17] D.W. Hands, « Popper and Lakatos in Economic Methodology », in U. Mäki, B. Gustafsson et C. Knudsen, (eds.), Rationality, Institutions & Economic Methodology, op.cit., pp. 61-75. J.J. Klant, « Refutability », in Methodus , vol. 2, n°2/1990, pp. 34-51.

[18] D.W. Hands, « Popper and Lakatos in Economic Methodology », op.cit., p. 64.

[19] K. Popper, Realism and the Aim of Science, Rowman & Littlefield, Totowa, NJ, 1983, p. xxxv.

[20] D.W. Hands, « Popper and Lakatos in Economic Methodology », op.cit., p. 65.

[21] D.W. Hands, Testing, Rationality and Progress: Essays on the Popperian Tradition in Economic Methodology, Rowman & Littlefield, Latham, NJ, 1992. D.M. Hausman, « An Appraisal of Popperian Methodology » in N. de Marchi, (ed), The Popperian Legacy in Economics, Cambridge University Press, cambridge, 1988, pp. 65-85. U. Mäki, « Economic Methodology: complaints and guidelines », in Finnish Economic Papers, vol.3, 1990, n°1, pp. 77-84.

[22] I. Lakatos, « Falsification and the Methodology of Scientific Research Programmes », in I. Lakatos et A. Musgrave, (eds.), Criticism and the Growth of Knowledge, Cambridge University Press, Cambridge, 1970, pp. 91-196.

[23] E.R. Weintraub, General Equilibrium Analysis, Studies in Appraisal, Cambridge University Press, Cambridge, 1985. M. Blaug, « Ripensamenti sulla rivoluzione keynesiana », in Rassegna Economica, vol. 51, n°3, 1987, pp. 605-634.

[24] G. Fulton, « Research Programmes in Economics », in History of Political Economy, vol. 16, n°2, 1984, pp. 27-55.

[25] R. Cross, « The Duhem-Quine thesis, Lakatos and the Appraisal of Theories in Macroeconomics », in Economic Journal, vol. 92, n°2, 1982, pp. 320-340.

[26] D.W. Hands, « Popper and Lakatos in Economic Methodology », op.cit., p. 68. Voir aussi D.W. Hands, « Second Thoughts on Lakatos », in , History of Political Economy, vol. 17, n°1, 1985, pp. 1-16.

[27] S.C. Dow, « Mainstream Economic Methodology »,op.cit, p. 80-81.

[28] Voir sur ce point la discussion in O. Hamouda et R. Rowley, « Ignorance and the Absence of Probabilities », in C. Schmidt, (ed.), Uncertainty in Economic Thought, Edwar Elgar, Cheltenham, 1996, pp. 38-64.

[29] J. Doherty, E. Graham et M. Malek, (eds.), Post-modernism in Social Sciences, Macmillan, Londres, 1992; voir en particulier l’introduction à ce volume. B. Barnes et D. Bloor, « Relativism, rationalism and the sociology of lknowledge », in M. Hollis et S. Lukes, (eds.), Rationality and Relativism , Basil Blackwell, Oxford, 1982, pp. 21-47.

[30] W. Jevons, The Theory of Political Economy, Macmillan, Londres, 1871, p. 266.

[31] M. Callon, (sous la direction de), La Science et ses réseaux , op.cit., pp. 25-31.

[32] Sur cette épistémologie, on se réfèrera à A.M. Carabelli, On Keynes’s Method, Macmillan, Londres, 1988; R.M. O’Donnel, Keynes’s Philosophy, Economics and Politics: The Philosophical Foundations of Keynes’s Thought and their influences on his Economics and Politics , Macmillan, Londres, 1989.

[33] S.C. Dow, « The appeal of neoclassical economics: some insights from Keynes’s epistemology », in Cambridge Journal of Economics , vol. 19, n°5, 1995, pp. 715-733, p. 716.

[34] J.M. Keynes, A Treatise on Probability , republié in Collected Writings , vol. VIII, Macmillan, Londres, 1973; voir le chapitre 6.

[35] Au sens où la totalité de la chaîne rethorique doit être validée pour que le résultat final le soit.

[36] Sur ce point voir le grand ouvrage de Gunnar Myrdal dont les opinions, exprimées en 1929, restent parfaitement d’actualité aujourd’hui. G. Myrdal, The Political Element in the Development of Economic Theory , Transaction Publishers, New Brunswick et Londres, 1990; première édition en anglais, 1954; première édition en suédois, 1930.

[37] O. Favereau, « Marchés internes, Marchés externes », in Revue Économique, vol.40, n°2, mars 1989, pp. 273-328

[38] U. Mäki, « How to combine rethoric and realism in the methodology of economics » in Economics and Philosophy, vol.4, avril 1988, pp. 353-373.

[39] T. Lawson, « Realism and instrumentalism in the development of econometrics », in Oxford Economic Papers, vol. 41, janvier 1989, pp. 236-258.

[40] C. Lloyd, Explanations in Social History, Basil Blackwell, Oxford, 1986.

[41] T. Lawson, « Realism, closed systems and Friedman », in Research in the History of Economic Thought and Methodology, vol. 10, 1992, pp. 196-215. U. Mäki, « Friedman and Realism », in Research in the History of Economic Thought and Methodology, vol. 10, 1992, pp. 171-195.

[42] U. Mäki, « Friedman and Realism », op.cit.. Idem, « On the Problem of Realism in Economics », in Ricerche Economiche, vol. 43, n°1-2, 1989, pp. 176-198. B.J. Caldwell, « Economic Methodology: Rationale, Foundation, Prospects », op.cit..

[43] U. Mäki, « How to combine rethoric and realism in the methodology of economics », op.cit..

[44] H. Brochier, « Pour un nouveau programme de recherches en économie », in Revue semestrielle du MAUSS, Pour une autre économie, n°3, La Découverte, Paris 1994, pp. 141-152

[45] T. Lawson, « Realism and … », op. cit..

[46] A.M. Carabelli, On Keynes’s Method …, op. cit..A. Fitzgibbons, Keynes’s vision , Oxford University Press, Oxford, 1988.

[47] M. Callon (sous la direction de), La Science…, op. cit..

[48] S.C. Dow, « Post-Keynesianism as political economy: a methodological discussion », in Review of Political Economy, vol.2, n°3, 1990, pp. 345-358; voir p. 349.

[49] Charles S, Macroéconomie hétérodoxe: de Kaldor à Minsky, Éditions L’Harmattan, 2006 et Lavoie M., L’économie postkeynésienne, Paris, La Découverte « Repères », 2004

[50] O. Favereau, « Marchés internes, Marchés externes », op. cit..

[51] S.C. Dow, « Post-Keynesianism as… », op.cit., pp.353 à 356.

[52] Voir ainsi les articles marquant le centenaire de la revue The Economic Journal. F.H. Hahn, « The next Hundred years », et E. Malinvaud, « The Next Fifty Years », in Economic Journal, vol. 101, n°404.

[53] U. Mäki, « Social Theories of Science and the Fate of Institutionalism in Economics », op.cit., p. 80.

[54] Au sens donné par L. Laudan, Progress and its Problems, Routledge & Keagan Paul, Londres, 1977, voir en particulier pp. 188-9 et p. 222.

[55] B. Ward, What’s Wrong with Economics, Basic Books, New York, 1972.

[56] U. Mäki, « Economics with Institutions », in U. Mäki, B. Gustafsson et C. Knudsen, (eds.), Rationality, Institutions & Economic Methodology, Routledge, Londres-New York, 1993, pp. 3-42.

[57]P. Diesing, Patterns of Discovery in Social Sciences , Routledge and Keegan Paul, Londres, 1972.

[58] A. Kaplan, The Conduct of Inquiry, Chandler, San Francisco, 1964.

[59] M. Aglietta, Régulation et crises du capitalisme , Calmann-Lévy, Paris, 1976. R. Boyer et J. Mistral, Accumulation, Inflation, Crises , PUF, Paris, 1978.

Jacques Sapir est un économiste français, aussi auteur d'ouvrages d'histoire militaire et de théorie politique. Docteur en économie et diplômé de Sciences Po Paris, il est directeur d'études à l'EHESS, directeur du Centre d'études des modes d'industrialisation (CEMI) et a récemment été élu membre de l'Académie des Sciences de Moscou. Connu du grand public pour son rejet de la monnaie unique, il a notamment publié : La Démondialisation (Le Seuil, 2011) ; Faut-il sortir de l'Euro ? (Le Seuil, 2012) et dernièrement Souveraineté, démocratie, laïcité (Michalon, 2012).

Commentaires

Bonjour,

Comment dès lors éviter la hiérarchie de concepts économiques et sociaux Sinon de laisser porter,d’accompagner le paroxysme,nourrir la pseudo compétition entre les tenants de pouvoirs sauvages incontrôlables; de la raison des plus forts.

Faute d’arguments à faire valoir. De ceux qui ont toujours un coup d’avance sur l’échiquier.Une aristocratie nécessaire(et contingence).Des déséquilibres,des inégalités comme des appriories utiles,une trajectoire dans un vide sidéré,un mouvement inflationniste qui poussent… irrésistiblement.

Le progrès(vrai)se ferait jour par la théorie du ruissellement induit. Une forme de logique,qui n’aurait d’autre alternative que la redistribution; ou le conservatisme indétrônable du profit;pouvoir,absolu,assis,à fin,unique.

Ce dernier postulat(infernal)ne tiendrait pas. Irrémédiablement, il serait rattrapé au terme d’un cycle qui finirait par habiter(hanter)l’esprit collectif.

Le temps est à l’équilibre précaire,(nature des choses et des êtres)en même temps, à l’ouvrage de lente maturation,(évolution)siège confronté à de fortes forteresses froides.

par philo'ofser - le 30 septembre, 2017

[…] aussi : L’économie est-elle une science ? (Jacques […]

par iPhilo » L’esprit malin du capitalisme - le 28 octobre, 2019

Laissez un commentaire